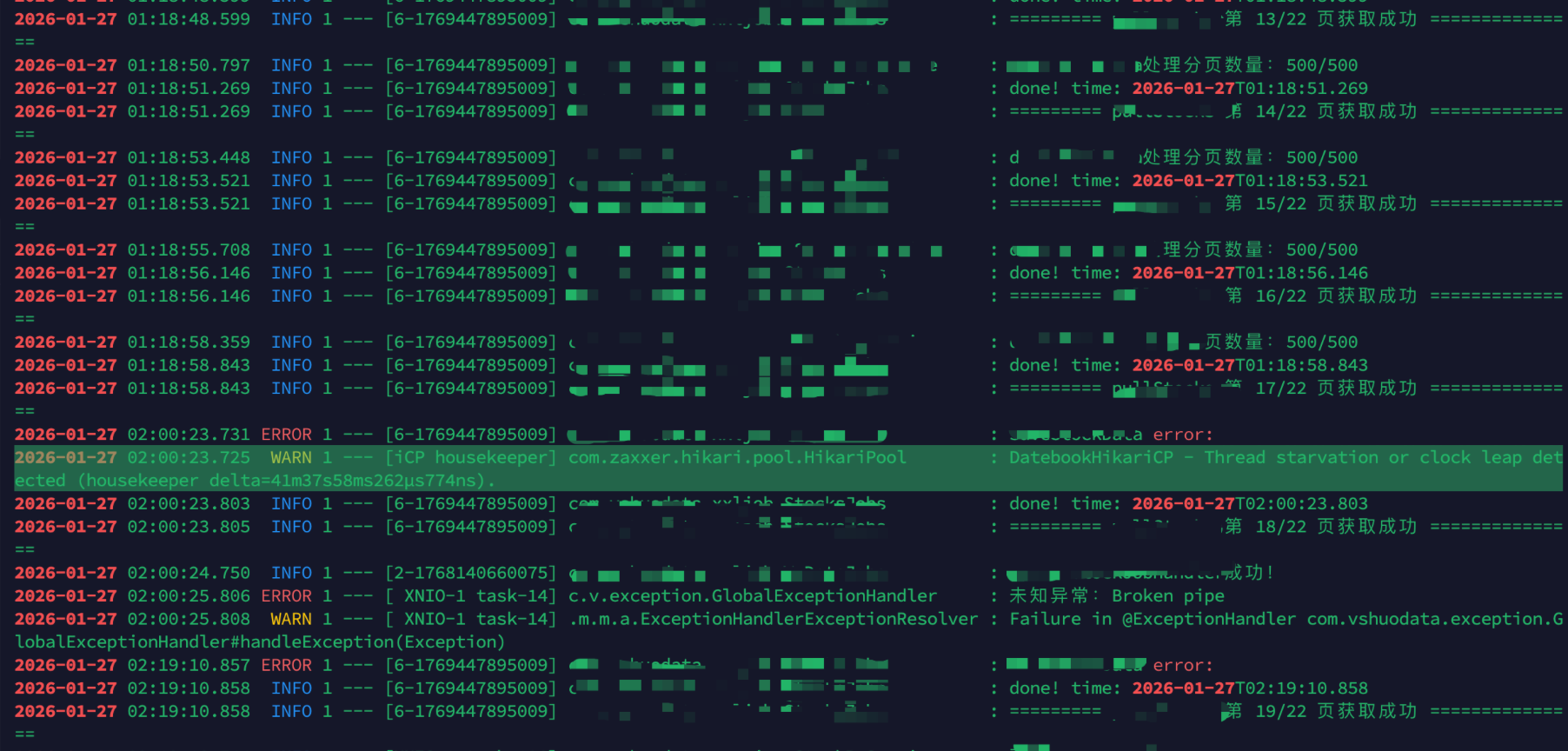

看到这个错误信息,第一反应可能是数据库连接池出问题了,但实际上 “Thread starvation or clock leap detected” 是一个典型的“系统健康状况”报警。

数据库 housekeeper 线程延迟了 41 分钟(delta=41m37s),这意味着在长达 41 分钟的时间里,HikariCP 的管理线程完全没有机会执行。

1. 深度复盘:41 分钟到底发生了什么?

在 8核 16G 的高性能服务器上,出现秒级的延迟尚可理解,但 41 分钟的停滞通常指向以下三个非代码层面的原因:

- 系统进入休眠(最常见于开发环境): 如果你在本地 Docker 运行应用,电脑进入睡眠模式,系统时钟会暂停。唤醒后,HikariCP 发现时间“跳变”了,便会发出警报。

- 云服务器 CPU 积分耗尽: 如果使用突发型实例(如 AWS t系列、阿里 t系列),积分耗尽后 CPU 会被强制压制到极低性能,应用几乎处于“封印”状态。

- 严重的 Stop-The-World (STW) GC: 由于未限制 JVM 内存,Java 8 可能会因为申请不到物理内存而频繁触发超长 Full GC,或者在 Swap(交换分区)中挣扎。

2. 诊断你的配置瓶颈

通过分析你之前的配置,我们发现了几个“不匹配”的风险点:

| 模块 | 当前痛点 | 风险 |

|---|---|---|

| JVM | 未指定 -Xmx |

Java 8 在 Docker 中会误判内存,导致 OOM 或频繁 Full GC。 |

| Undertow | Worker 线程 (200) 过多 | 线程上下文切换开销大,且远超数据库连接池处理能力。 |

| Undertow | Buffer Size (1024) 太小 | 高并发下 I/O 吞吐量受限。 |

| HikariCP | 连接池 (5~20) 动态伸缩 | 频繁创建/销毁连接会产生性能抖动,建议固定大小。 |

3. 生产级优化方案 (8核 16G 环境)

3.1 优化 Dockerfile:赋予 JVM “超能力”

不要让 Java 盲目猜测内存。针对 16G 宿主机,我们分配 8G 堆内存,并启用更适合大内存的 G1 垃圾回收器。

Dockerfile

1 | FROM amazoncorretto:8 |

3.2 优化 YAML:平衡 Web 与 数据库

将 Undertow 的处理能力与 HikariCP 的承受能力相匹配,避免“交通拥堵”。

YAML

1 | server: |

4. 终极排查清单

如果优化配置后,报错依然存在且 delta 依然巨大,请执行以下操作:

- 排查宿主机状态: 执行

top命令查看%st(Steal Time)。如果该值很高,说明你的云服务商在限制你的 CPU。 - 监控 GC 情况: 在容器内运行

jstat -gcutil <pid> 1000,观察FGC(Full GC 次数)和FGCT(Full GC 总时间)。 - 检查 Docker 限制: 确保 Docker 启动命令中没有设置过小的

--memory限制(例如只给了容器 512MB,但你 JVM 却想申请 8GB)。

结语

“Thread starvation”通常是系统资源告急的求救信号。通过固定连接池大小、合理限制 JVM 堆内存以及选择现代 GC 算法,你可以规避 90% 的性能抖动。