前后端分离的项目,接口文档的存在十分重要。与手动编写接口文档不同,swagger是一个自动生成接口文档的工具,在需求不断变更的开发环境下,手动编写文档的效率实在太低。与新版的swagger3相比swagger2配置更少,使用更加方便。

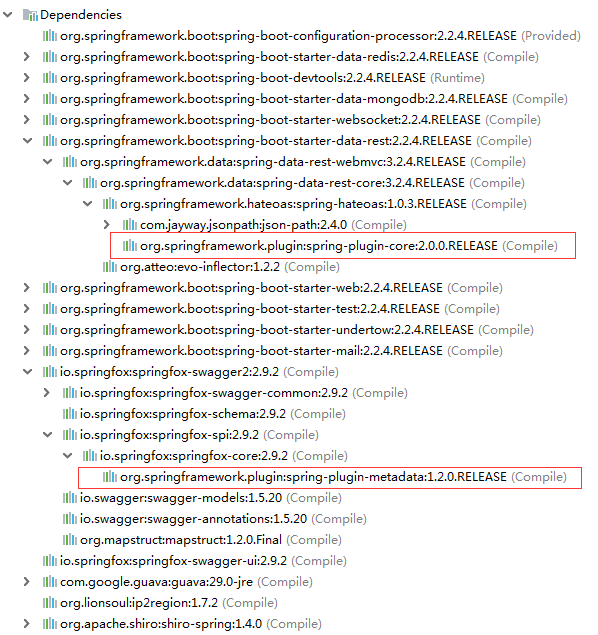

一、pom文件中引入Swagger3依赖

1 | <dependency> |

二、Application上面加入@EnableOpenApi注解

1 |

|

三、Swagger3Config的配置

1 |

|

四、Swagger注解的使用说明

1 | :用在请求的类上,表示对类的说明 |

Controller层的配置:

1 |

|

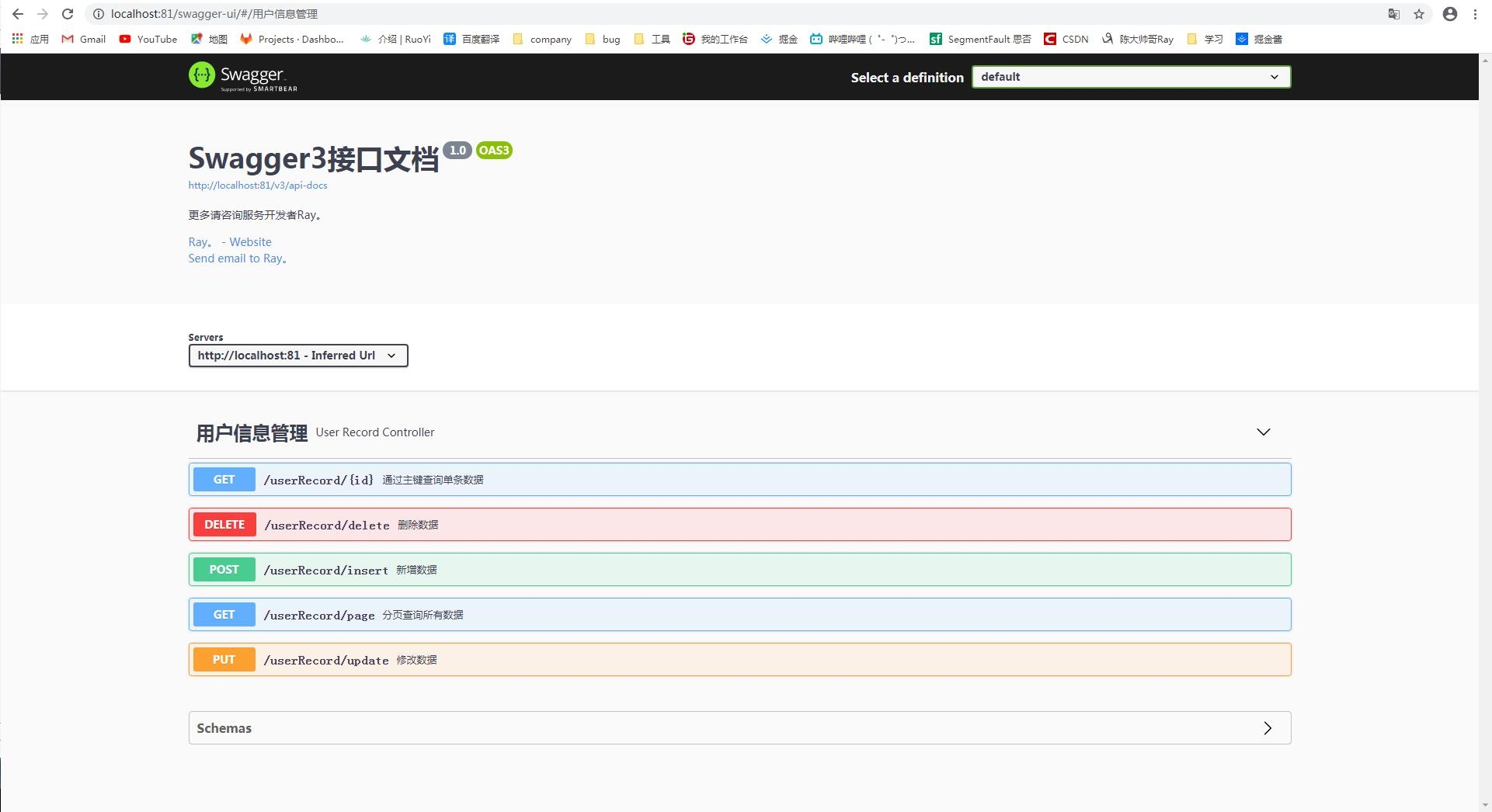

五、Swagger界面效果

Swagger的访问路径由port/swagger-ui.html改成了port/swagger-ui/ 或port/swagger-ui/index.html